Data Mining – hay còn được gọi là “khai thác dữ liệu” – là một khái niệm quen thuộc trong lĩnh vực khoa học máy tính. Đối với những ai đam mê công nghệ và dữ liệu, việc tìm hiểu về Data Mining không chỉ giúp mở rộng kiến thức mà còn giúp áp dụng hiệu quả vào thực tế.

LaGiNhi.com mang đến bài viết này để giúp bạn hiểu rõ hơn về Data Mining, từ cơ bản đến các ứng dụng thực tiễn. Hãy cùng khám phá và tìm hiểu thêm về Data Mining cùng chúng tôi!

Bạn đang xem: Data Mining là gì? Công cụ khai phá dữ liệu phổ biến

Khái Niệm

Data Mining là thuật ngữ chỉ việc xử lý một kho dữ liệu khổng lồ. Trong Data Mining, công việc chính là quá trình tính toán, phân tích và sắp xếp các mẫu trong các bộ dữ liệu lớn để thiết lập các mối liên hệ và dễ dàng giải quyết nhiều vấn đề khác trong tương lai.

Công việc này giúp các doanh nghiệp lớn xác định được trào lưu, xu hướng tương lai. Đây là một quá trình phức tạp và khó khăn vì phải làm việc với kho dữ liệu lớn và nhiều công cụ hỗ trợ khác.

Ngoài ra, đây không chỉ tập trung vào việc trích xuất dữ liệu mà còn đòi hỏi việc chuyển đổi, suy xét và suy luận mô hình, xuất kết quả các cấu trúc đã phân tích và phân tích thêm nhiều vấn đề khác.

Phương pháp khai thác dữ liệu

Hiện nay, có 6 phương pháp chính trong việc khai thác dữ liệu:

- Phân loại (Classification): Phương pháp này tập trung vào việc dự báo và phân loại các đối tượng.

- Hồi quy (Regression): Mục tiêu của phương pháp này là giúp khám phá và ánh xạ dữ liệu.

- Phân nhóm (Clustering): Phương pháp này giúp phân nhóm và mô tả dữ liệu phổ biến, hỗ trợ người làm mô tả dữ liệu bằng cách xác định các cụm hữu hạn.

- Tóm tắt (Summarization): Phương pháp này cho phép tìm một tóm tắt dữ liệu ngắn gọn.

- Mô hình ràng buộc (Dependency modeling): Người sử dụng sẽ tìm mô hình cục bộ mô tả sự phụ thuộc dữ liệu dựa trên phương pháp mô hình ràng buộc.

- Phát hiện biến đổi và độ lệch (Change and Deviation Detection): Mục tiêu của phương pháp này là tìm ra những thay đổi quan trọng.

Tính năng chính của Data Mining

Data Mining có 5 đặc điểm chính:

- Dự đoán mẫu

- Dự báo kết quả trước

- Tạo thông tin hỗ trợ cho việc phân tích

- Phân tích và suy diễn cho dữ liệu lớn

- Phân nhóm dữ liệu một cách trực quan

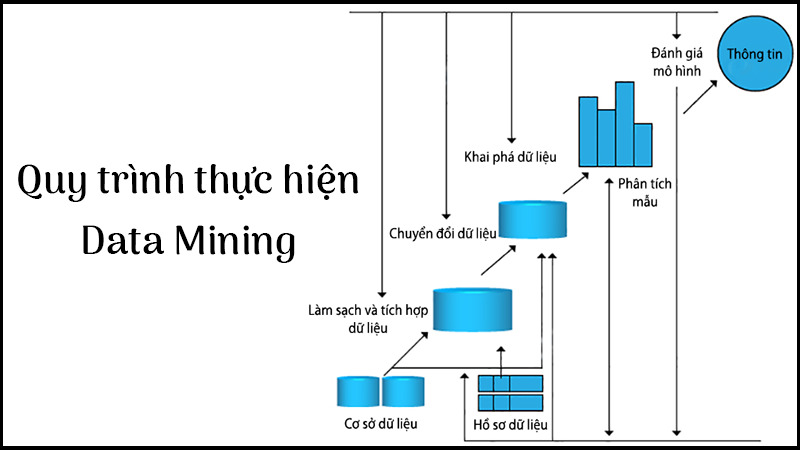

Quy trình thực hiện Data Mining

Trong quy trình thực hiện Data Mining, có tổng cộng 7 bước:

- Làm sạch dữ liệu: Bước này đứng đầu trong quá trình khai thác dữ liệu. Việc làm sạch dữ liệu đóng vai trò quan trọng vì việc sử dụng dữ liệu không đúng cách có thể dẫn đến sự nhầm lẫn và kết quả không chính xác.

- Tích hợp dữ liệu: Quá trình này giúp nâng cao độ chính xác và tốc độ của việc khai thác dữ liệu.

- Làm giảm dữ liệu: Mục tiêu là giảm kích thước của dữ liệu mà vẫn giữ nguyên tính toàn vẹn.

- Chuyển đổi dữ liệu: Dữ liệu được chuyển đổi thành dạng phù hợp cho quá trình khai thác. Việc hợp nhất dữ liệu giúp quá trình khai thác trở nên hiệu quả hơn và mẫu dữ liệu dễ hiểu hơn.

- Khai thác dữ liệu: Là quá trình xác định mẫu và suy luận từ dữ liệu lớn.

- Đánh giá mẫu: Bao gồm xác định mẫu đại diện cho kiến thức dựa trên thước đo, xác định kiến thức cần thiết và loại bỏ phần thừa. Sử dụng các phương pháp trực quan hóa và tóm tắt dữ liệu để người dùng hiểu dễ dàng.

- Trình bày thông tin: Dữ liệu được trực quan hóa thành báo cáo, bảng, v.v. để chuyển giao cho các đơn vị xử lý thông tin.

Ứng dụng Data Mining trong đời sống

Data Mining đang được áp dụng rộng rãi trong cuộc sống hàng ngày, đặc biệt là trong các lĩnh vực:

- Nhà cung cấp dịch vụ di động

- Khu vực bán lẻ

- Trí tuệ nhân tạo

- Thương mại điện tử

- Khoa học và Kỹ thuật

- Phòng chống tội phạm

Ngoài ra, Data Mining cũng được ứng dụng trong lĩnh vực kinh tế, tiếp thị, chăm sóc sức khỏe, và quan trọng hơn, chăm sóc khách hàng.

RapidMiner

RapidMiner đưa trí tuệ nhân tạo vào doanh nghiệp thông qua nền tảng khoa học dữ liệu mở và mở rộng. Dành cho các nhóm phân tích, RapidMiner tập trung vào toàn bộ quá trình khoa học dữ liệu từ chuẩn bị dữ liệu tới học máy và triển khai mô hình dự đoán. Hơn 700.000 chuyên gia phân tích sử dụng sản phẩm của RapidMiner để tăng doanh thu, giảm chi phí và giảm rủi ro.

RapidMiner được áp dụng trong lĩnh vực thương mại và doanh nghiệp cũng như trong nghiên cứu, giáo dục, đào tạo, tạo mẫu nhanh và phát triển ứng dụng. RapidMiner dựa trên nền tảng Java độc lập và hoạt động trên mọi hệ điều hành hỗ trợ Java Runtime Environment (JRE).

Xem thêm : IMBA là gì? Top 10 vị tướng mạnh nhất game Dota 2 bạn nên thử

RapidMiner dễ sử dụng, hỗ trợ nhanh chóng các loại cơ sở dữ liệu, cung cấp nhiều tính năng và giúp tiết kiệm thời gian bằng cách lưu trữ biến đổi để tái sử dụng trong các phân tích mới. Tuy nhiên, việc chia sẻ các phân tích từ RapidMiner Studio khó khăn và chỉ miễn phí cho 10.000 dòng đầu tiên – vượt quá số lượng này sẽ yêu cầu chi trả một khoản phí đáng kể.

Weka

Waikato Môi trường cho Phân tích Kiến thức (Weka), được phát triển tại Đại học Waikato, New Zealand, là một phần mềm miễn phí được cấp phép theo Giấy phép Công cộng GNU và đi kèm với cuốn sách “Data Mining: Công cụ và Kỹ thuật Học máy Thực tiễn”.

Weka bao gồm một bộ công cụ và thuật toán trực quan để phân tích dữ liệu và dự đoán mô hình, cùng với giao diện người dùng đồ họa giúp truy cập dễ dàng vào các chức năng này.

Weka hỗ trợ một số công việc khai thác dữ liệu tiêu chuẩn, bao gồm xử lý trước dữ liệu, phân nhóm, phân loại, hồi quy, trực quan hóa và chọn tính năng. Để sử dụng Weka, máy tính cần có Java 1.7 trở lên.

Weka có thể sử dụng trên bất kỳ nền tảng hỗ trợ Java nào và là phần mềm mã / mở. Ngoài ra, Weka cung cấp các khóa học trực tuyến miễn phí hướng dẫn cách sử dụng. Một hạn chế của Weka là yêu cầu nhiều bộ nhớ khi chạy trên Java, tuy nhiên có thể giảm bớt bằng cách sử dụng Giao diện dòng lệnh (CLI) để xử lý dữ liệu lớn.

Mặc dù là phần mềm mã / mở, một số trường hợp có thể yêu cầu người dùng mua giấy phép từ một hoặc nhiều tổ chức. Ngoài ra, máy chủ lưu trữ dữ liệu WEKA WIKI (wikispaces) đã ngừng hoạt động, dẫn đến việc cung cấp thông tin về nơi lưu trữ dữ liệu trong tương lai đang chưa sẵn sàng.

KNime: Nền Tảng Phân Tích Dữ Liệu Mạnh Mẽ

KNime (Konstanz Information Miner) là một nền tảng phân tích, báo cáo và tích hợp dữ liệu mã / mở và miễn phí. Với việc tích hợp các thành phần khác nhau cho máy học và khai thác dữ liệu theo khái niệm “Lego of Analytics”, KNime đem đến sự linh hoạt và hiệu quả cho người dùng. Giao diện người dùng đồ họa và việc sử dụng JDBC cho phép tập hợp các nút kết hợp các / dữ liệu khác nhau, bao gồm tiền xử lý (ETL: Extraction, Transformation, Loading), lập mô hình, phân tích và trực quan hóa dữ liệu mà không cần hoặc chỉ lập trình tối thiểu.

Ứng dụng KNime không chỉ dừng lại trong lĩnh vực nghiên cứu dược phẩm mà còn được sử dụng rộng rãi trong các lĩnh vực như phân tích dữ liệu khách hàng CRM, kinh doanh thông minh, khai thác văn bản và phân tích dữ liệu tài chính. Với khả năng hoạt động trên các hệ điều hành Linux, Windows (XP trở lên) hoặc MacOS, KNime đem lại sự tiện lợi và linh hoạt cho người dùng.

KNime cho phép thao tác và xử lý tập dữ liệu lớn cũng như quản lý nhiều người dùng và quy trình làm việc. Tuy nhiên, việc quản lý dữ liệu cần được thực hiện một cách cẩn thận để tránh mất mát dữ liệu và sự rườm rà. Cùng với đó, KNime cũng gặp phải một số thách thức như nhập dữ liệu và hợp nhất nhiều tệp.

Apache Mahout

Apache Mahout là một dự án của Apache Software Foundation nhằm tạo ra các triển khai miễn phí các thuật toán học máy phân tán hoặc có thể mở rộng, tập trung chủ yếu vào đại số tuyến tính. Mahout cũng cung cấp các thư viện Java/Scala cho các phép toán thông thường (tập trung vào đại số tuyến tính và thống kê) và các bộ sưu tập Java nguyên thủy.

Apache Mahout là một dự án của Apache Software Foundation nhằm tạo ra chương trình triển khai miễn phí các thuật toán học máy phân tán, mở rộng và tập trung chủ yếu vào đại số tuyến tính. Khi trước, ứng dụng này đòi hỏi máy sử dụng nền tảng Apache Hadoop, tuy nhiên ngày nay nó chủ yếu tập trung vào Apache Spark.

Apache Mahout được đánh giá là dễ sử dụng và tốc độ khai phá nhanh cùng với những tính năng khai phá dữ liệu phức tạp. Tuy nhiên, điểm trừ của nó là các thuật toán không đa dạng, không có sẵn những quá trình khai phá tự động và hệ thống quản lý dữ liệu không được đánh giá cao.

Công cụ Khai Phá Dữ Liệu của Oracle

Xem thêm : Âm nhạc là gì? Nguồn gốc và các lợi ích mang đến trong cuộc sống

Công cụ Khai Phá Dữ Liệu của Oracle (ODM) là một phần của Tùy Chọn Cơ Sở Dữ Liệu Phân Tích Nâng Cao của Oracle, cung cấp các thuật toán khai thác dữ liệu mạnh mẽ cho việc phân tích dữ liệu chi tiết. ODM không chỉ giúp dự đoán và tận dụng dữ liệu mà còn giúp tối ưu hóa đầu tư của bạn vào Oracle. Với ODM, bạn có thể xây dựng và triển khai các mô hình dự đoán trực tiếp trong Cơ Sở Dữ Liệu Oracle. Điều này giúp bạn dự đoán hành vi của khách hàng, tập trung vào khách hàng tiềm năng tốt nhất của mình, xây dựng hồ sơ khách hàng, phát hiện cơ hội bán hàng chéo và phát hiện các hành vi bất thường cũng như gian lận tiềm ẩn.

Công cụ Khai Phá Dữ Liệu của Oracle cung cấp các công cụ để tạo, quản lý và triển khai các hoạt động của các mô hình khai phá dữ liệu trong môi trường cơ sở dữ liệu.

Công cụ Khai Phá Dữ Liệu của Oracle đảm bảo bảo mật dữ liệu cao và có hệ thống quản lý dữ liệu xuất sắc. Ngoài ra, ứng dụng này cung cấp hỗ trợ người dùng cũng như hướng dẫn sử dụng để giúp bạn giải quyết các vấn đề phát sinh. Tuy nhiên, có điểm yếu là hệ thống sao lưu dữ liệu không được xử lý một cách hiệu quả.

TeraData

Teradata là một công ty phần mềm doanh nghiệp chuyên phát triển và cung cấp các giải pháp phân tích cơ sở dữ liệu. Với mạng lưới hoạt động tại Bắc Mỹ, Latinh, Châu Âu, Trung Đông, Châu Phi và Châu Á, Teradata đưa đến ba dịch vụ chính: phân tích kinh doanh, sản phẩm đám mây và tư vấn.

Nền tảng phân tích của Teradata không chỉ cung cấp các chức năng hàng đầu mà còn hỗ trợ người dùng tận dụng đa dạng công cụ và ngôn ngữ trên quy mô lớn, từ đó khai thác hiệu quả trên nhiều loại dữ liệu khác nhau.

Điểm mạnh của Teradata là khả năng tích hợp phân tích dữ liệu trực tiếp vào dữ liệu gốc, loại bỏ bước chuyển dữ liệu và tạo điều kiện cho việc thực hiện phân tích trên các tập dữ liệu lớn với tốc độ và độ chính xác cao. Tuy nhiên, để tận dụng hết tiềm năng của ứng dụng, việc nâng cấp hệ thống phân tích và bộ nhớ sẽ là yếu tố không thể bỏ qua.

Data Mining là gì? Với nhiều người, Data Mining có thể là một khái niệm xa lạ. Tuy nhiên, thực tế, đây là một lĩnh vực quan trọng trong khoa học máy tính. Bắt đầu với việc xử lý các tập dữ liệu lớn, công việc chính của Data Mining là phân tích và sắp xếp các mẫu để tìm ra mối liên hệ và giải quyết các vấn đề khác. Việc này giúp doanh nghiệp dự đoán trào lưu và xu hướng tương lai, một quá trình phức tạp nhưng cần thiết.

Phương pháp khai phá dữ liệu hiện tại bao gồm 6 phương pháp chính như Phân loại, Hồi quy, Phân nhóm, Tổng hợp, Mô hình ràng buộc và Dò tìm biến đổi và độ lệch. Mỗi phương pháp đều có vai trò riêng trong việc phân tích dữ liệu và đưa ra những suy luận có giá trị.

Tính năng chính của Data Mining bao gồm Dự đoán mẫu, Đoán trước kết quả, Xây dựng thông tin hỗ trợ phân tích, Phân tích và suy luận dữ liệu lớn, và Chia nhóm dữ liệu trực quan. Những tính năng này đóng vai trò quan trọng trong việc hỗ trợ quyết định và phát triển kinh doanh.

Quy trình thực hiện Data Mining đòi hỏi 7 bước, từ việc làm sạch dữ liệu, tích hợp, giảm dữ liệu, chuyển đổi, khai thác dữ liệu, đánh giá mẫu đến trình bày thông tin. Mỗi bước đều quan trọng và đóng góp vào việc hiểu rõ dữ liệu và đưa ra những kết luận hữu ích.

Ứng dụng của Data Mining rộng lớn trong đời sống hàng ngày, từ nhà cung cấp dịch vụ di động, khu vực bán lẻ, trí tuệ nhân tạo đến phòng chống tội phạm. Nó cũng có ứng dụng trong kinh tế, tiếp thị, chăm sóc sức khỏe và chăm sóc khách hàng.

Cuối cùng, có nhiều công cụ khai phá dữ liệu hữu ích như RapidMiner, Weka, KNime, Apache Mahout, Oracle Data Mining, TeraData và Orange. Mỗi công cụ đều có những ưu điểm và hạn chế riêng, phù hợp với các mục đích sử dụng khác nhau. Điều quan trọng là lựa chọn công cụ phù hợp để tận dụng tối đa tiềm năng của Data Mining.

Nguồn: https://laginhi.com

Danh mục: News